Was ist ein neuronales Netz?

Digitalisierung / Industrie 4.0Begriffe rund um die KI, Maschinelles Lernen und neuronale Netze erklärt

Was ist ein neuronales Netz? Was maschinelles Lernen? Begriffe, die oft gleich benutzt werden, sich aber ihrer Definition nach unterscheiden. Wir erklären, was es mit ihnen auf sich hat.

In unserem ersten Teil zum Thema Künstliche Intelligenz (KI) haben wir uns die Frage gestellt, was eine KI ist, was sie kann und wie sie allmählich in unserer Alltagswelt Einzug hält. Jetzt geht es ans Eingemachte: Wie genau funktioniert die derzeit populärste Form der KI, das neuronale Netz?

Was ist was? Begriffe definiert

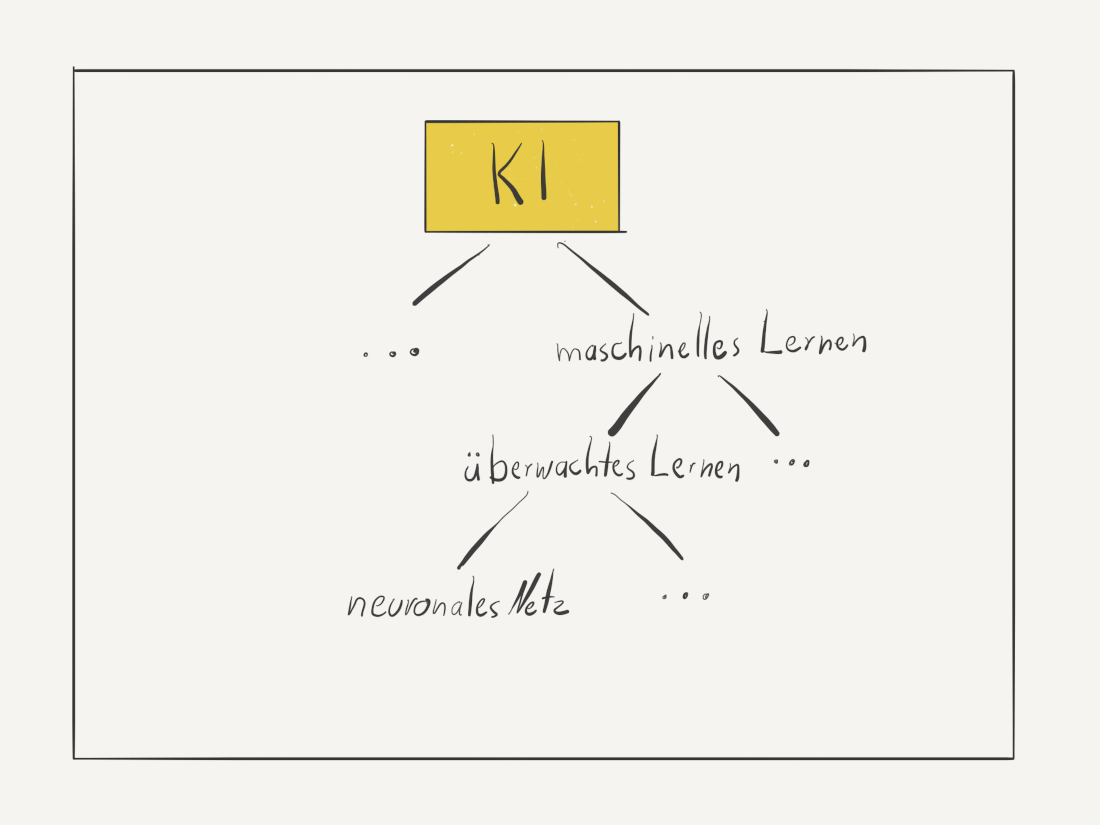

Die Begriffe KI, maschinelles Lernen und neuronale Netze fallen häufig in Artikeln rund um neue Technologien. Wenngleich die Begriffe alle Ähnlichkeiten aufweisen und immer öfter synonym verwendet werden, ist es doch wichtig, diese zu unterscheiden. KI steht als Überbegriff für den Versuch, einem Computer menschliches oder komplexes Denken beizubringen – im Gegensatz zu dem stumpfen Abarbeiten von feststehenden, einmal vorprogrammierten Funktionen. Der Computer programmiert sich selbst, er lernt aus Erfahrung und ist in der Lage, mit neuen Situationen umzugehen.

Maschinelles Lernen definiert als Teildisziplin der Künstlichen Intelligenz

Es gibt viele verschiedene Wege, dieses Ziel zu erreichen. So zählen Suchmaschinen wie Google zu den KIs. Eine spezielle Methode innerhalb der KI ist das maschinelle Lernen. Es stellt den Ansatz dar, einem Computer das Lernen aus Erfahrung beizubringen. Das heißt: Ein Computer lernt aus allgemeinen Daten ein Muster, eine Regel abzuleiten, dass diesem bestmöglich entspricht und kann es auf neue Daten anwenden. Etwa einen Apfel von einer Birne zu unterscheiden.

Dabei kommt immer ein Wahrscheinlichkeitswert heraus, denn der Computer wird mit neuen, bisher unbekannten Daten konfrontiert und errechnet daraus die beste Näherung - er kann sich aber auch irren. Das ist genau wie bei uns – denn auch wir könnten zum Beispiel eine Nashi-Birne, die aussieht wie ein Apfel, für einen echten Apfel halten. Mit dem Unterschied, dass KIs, einmal trainiert, besser entscheiden als Menschen es tun könnten.

Innerhalb des maschinellen Lernens gibt es verschiedene Ansätze, selbstlernende Systeme zu programmieren. Diese unterteilen sich in einerseits überwachtes und andererseits unüberwachtes Lernen. Während bei Ersterem ein Mensch dem Computer mitteilt, was er lernen soll („Dieses Bild von einem Apfel ist ein Apfel, lerne, auch neue Bilder als Apfel zu erkennen!“) muss der Computer bei Letzterem selbst Strukturen in den Daten finden und diese sortieren – dafür können aber nur Menschen diese interpretieren.

Was ist ein neuronales Netz?

Neuronale Netze sind nun als Teil des überwachten Lernens wiederum das derzeit relevanteste Teilgebiet des maschinellen Lernens. Sie sind für den derzeitigen Trubel um die KI verantwortlich, denn sie sind in der Lage, große Mengen an unstrukturierten Daten besonders gut auszuwerten und Muster in ihnen zu finden. Zu unstrukturierten Daten gehören Bilder, Videos oder Töne, also all jene Daten, wir in unserem Alltag in großer Menge produzieren.

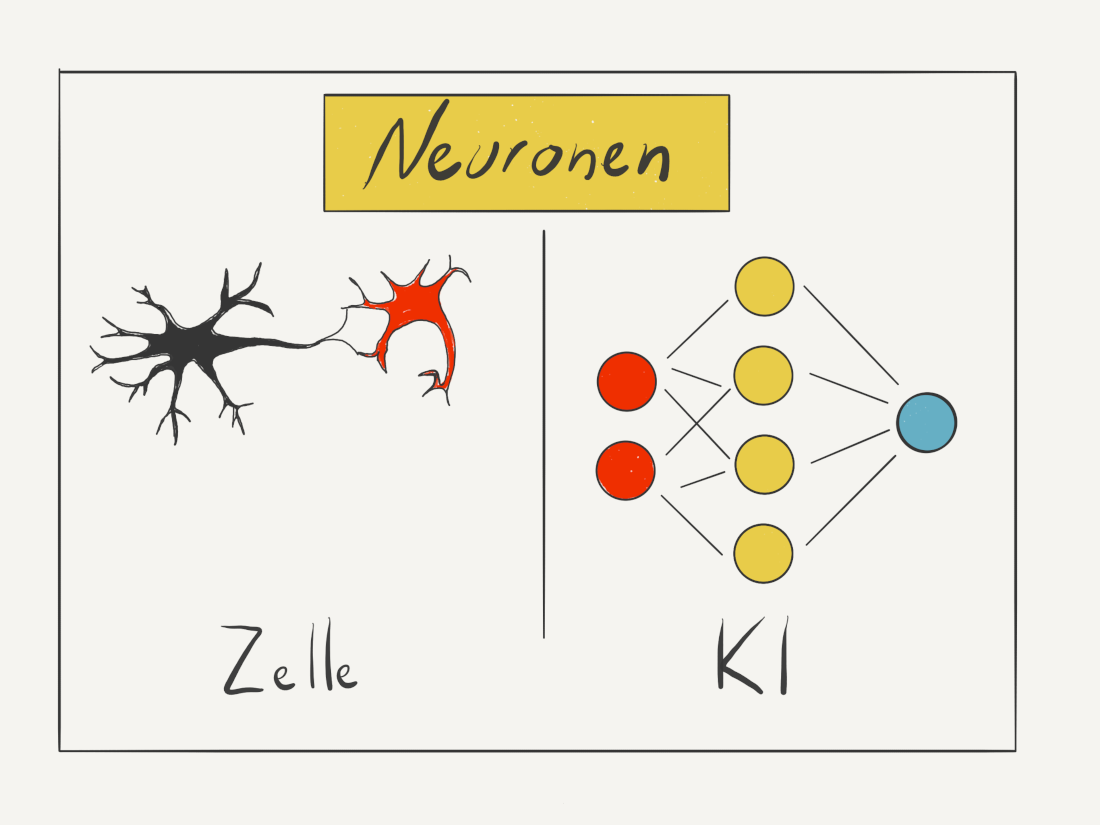

Sie leihen sich ihren Begriff aus der Biologie aus. Im menschlichen Gehirn ist ein Neuron eine Nervenzelle, die mit anderen Nervenzellen verbunden ist und elektrische Signale an diese weitergibt. Aus Milliarden von Neuronen setzt sich das Gehirn zusammen und aus ihrer Aktivität unser Geist.

Ein künstliches neuronales Netz funktioniert ähnlich: Hier ist ein Neuron eine mathematische Formel, die einen Input verarbeitet und daraus einen Output generiert. Die Werte der Formel werden dabei durch die Ausgangsdaten definiert. Viele künstliche Neuronen arbeiten zusammen und ergeben so ein künstliches neuronales Netz (KNN).

Beispiel für ein neuronales Netz

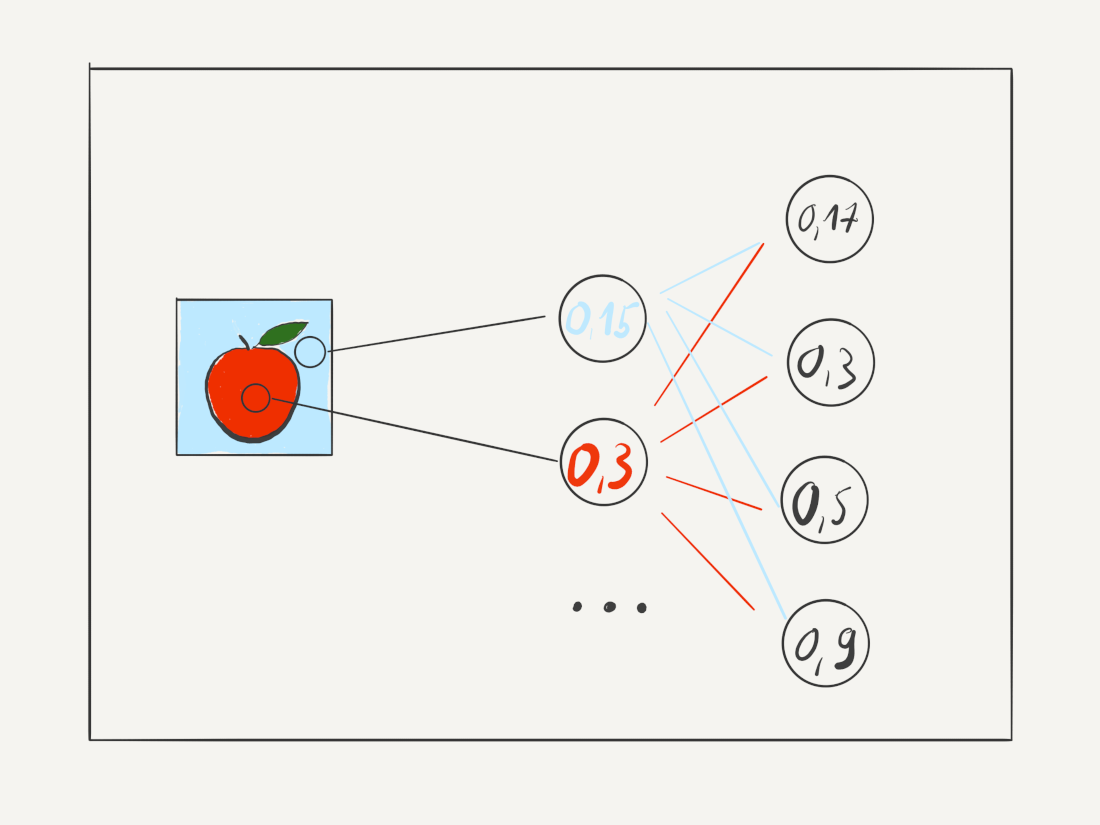

Nehmen wir als Beispiel ein neuronales Netz, das Bilder von Äpfel von Bildern von Birnen unterscheiden soll. Damit neuronale Netze funktionieren, benötigen sie Daten, deren Ergebnis sie kennen, um aus diesen zu lernen. Dieser Prozess wird „Training“ genannt – das Netz führt eine Berechnung aus und schaut, ob diese zum erwarteten Ergebnis passt. In unserem Beispiel braucht unser Netzwerk also Bilder von Äpfeln und Birnen, die mit einer Beschriftung versehen sind, was von beiden sie sind. Was das neuronale Netz macht ist jetzt folgendes: Es nimmt ein Bild, löst die einzelnen Pixel in Daten auf (zum Beispiel einen Farbwert) und berechnet dann mit diesen Daten in einer komplexen Formel ein Ergebnis, das sie danach mit der Beschriftung vergleicht.

Stimmen Ergebnis der Formel und Beschriftung überein, hat das Netzwerk ein Bild richtig erkannt.

Stimmen Ergebnis der Formel und Ergebnis nicht überein, stimmt die Berechnung noch nicht und es muss noch weitertrainieren.

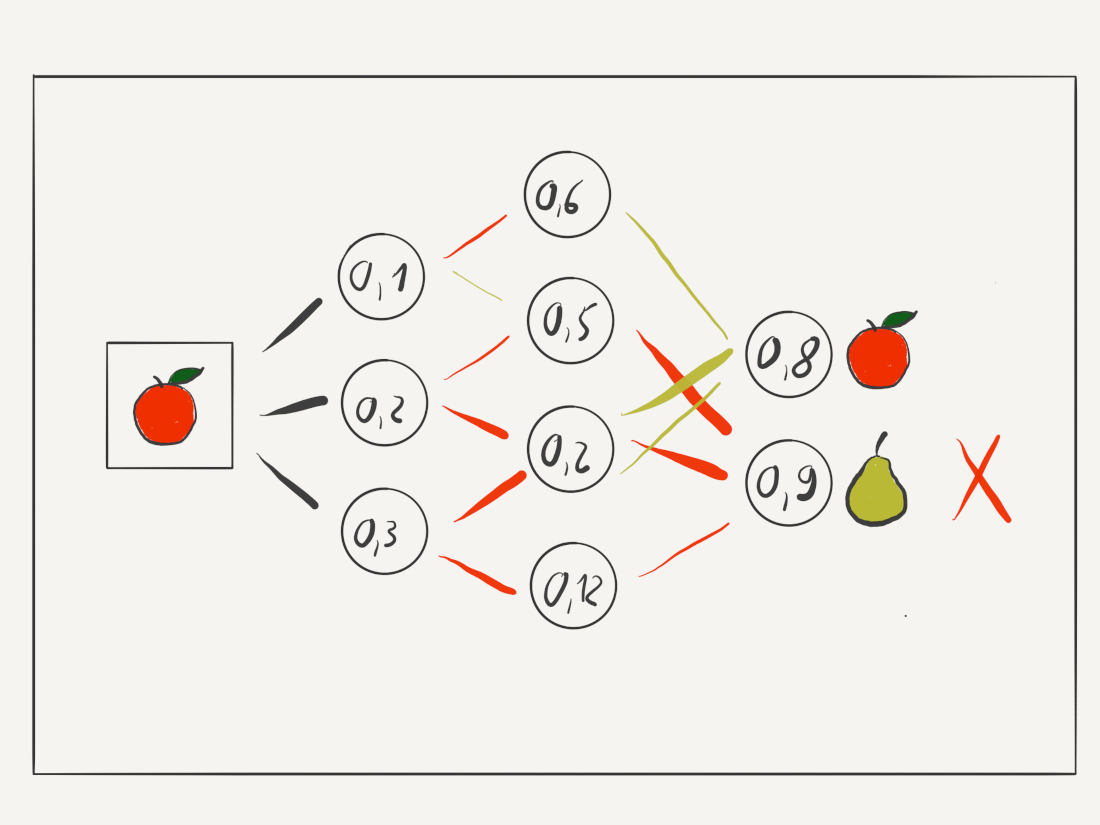

Wie ist ein neuronales Netz nun aufgebaut? Es gibt sehr unterschiedliche Formen neuronaler Netze aber grundsätzlich besteht es aus mehreren Ebenen: Einer Input-Ebene, die ein Signal aufnimmt, verschiedene Zwischenebenen, welche Berechnungen vornehmen und eine Output-Ebene, welches das Ergebnis der Berechnung bereitstellt. In unserem Beispiel haben wir ein neuronales Netz aufgebaut mit einer Inputebene, einer Zwischenebene und einer Outputebene (siehe Bild oben, rechts).

Das Neuron der ersten Ebene nimmt nun den Input (den Farbwert des Pixels) und verarbeitet diese Information (berechnet eine Formel) und gibt danach das Ergebnis an die nächste Ebene mit Neuronen weiter.

Die letzte Ebene mit Neuronen entspricht dann den beiden möglichen Outputs – Apfel oder Birne. Je nachdem, bei welchem der beiden Output-Neuronen das Ergebnis der Berechnung höher ist (in diesem Fall: näher am Wert 1 liegt), gibt das Netzwerk das Ergebnis als "Apfel" oder "Birne" heraus.

In unserem Beispiel (siehe oben) ist das Ergebnis dieser Berechnung aber falsch - der Wert bei "Birne" ist höher als bei "Apfel", obwohl das Bild einen Apfel zeigt. Das ist aber okay so, denn wenn ein neuronales Netz zum ersten Mal mit Daten gefüttert wird, sind seine Ergebnisse immer zufällig und können daher auch zufällig falsch sein. Das liegt daran, dass die Parameter der mathematischen Formeln beim ersten Trainingsdurchgang zufällig gewählt werden müssen, denn Programmierer kennen die genaue Formel ja nicht, mit der es möglich ist, Äpfel und Birnen voneinander zu unterscheiden (sonst bräuchten sie ja keine KI).

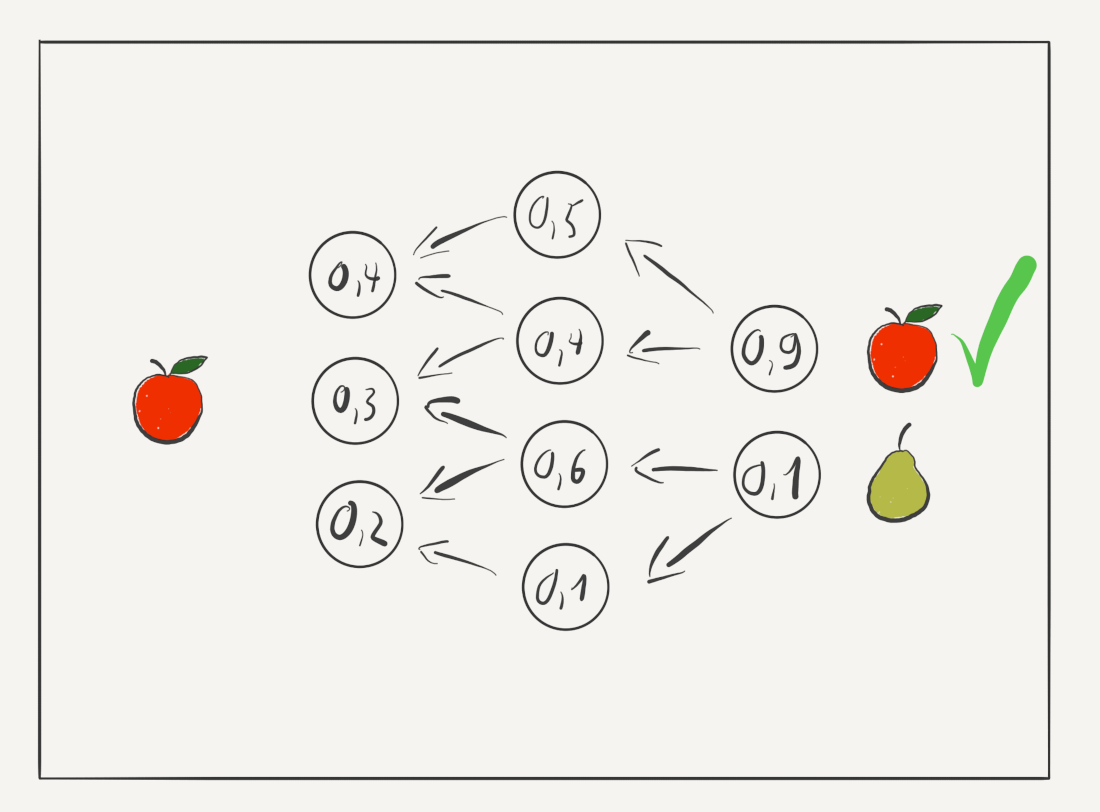

Jetzt kommt aber der wichtige Schritt: Die zufälligen Werte der einzelnen Neuronen werden nun ausgehend vom Ergebnis so angepasst, dass sie das richtige Ergebnis berechnen. Das macht das Netz automatisch durch eine weitere komplexe Formel. Es ist ein bisschen so wie im Matheunterricht: 2+X=4. "2" ist der Input, "4" der Output - welchen Wert muss also "X" haben, damit das korrekte Ergebnis herauskommt?

Ein neuronales Netz löst diese Berechnung nicht durch Wissen, sondern durch Ausprobieren – es optimiert die einzelnen Werte in den Neuronen solange, bis das tatsächliche Ergebnis dem gewünschten Ergebnis entspricht. Dabei werden üblicherweise tausende von Parametern gleichzeitig angepasst, in vielen sehr kleinen Schritten.

Diese Schritte werden nun wiederholt – viele tausende bis Millionen Male und nicht nur mit einem Bild, sondern mit vielen verschiedenen Bildern von Äpfeln und Birnen. Jedes Mal verändern sich die Neuronenwerte dabei ein wenig. Sie werden ein klein wenig besser darin, Äpfel und Birnen zu unterscheiden, da die Anzahl der Beispiele, die sie richtig zugeordnet haben, stetig wächst. Dieser Prozess heißt „Lernen“ und ist ungeheuer rechenaufwändig.

Am Ende dieses Prozesses sind die Neuronen dann aber so fit, dass sie Bilder von Äpfeln von denen von Birnen unterscheiden können. Und hier kommt nun die „Magie“ ins Spiel: Das neuronale Netz kann nicht nur die Bilder unterscheiden, die es bereits kennt und gelernt hat, richtig einzuordnen. Es kann dies auch bei Bildern, die es noch nie gesehen hat. Das Netz hat von den Trainingsbildern ein allgemeines Muster abstrahiert, das es nun auf neue Bilder anwenden kann.

Die Unterscheidungsmerkmale von Äpfeln und Birnen hat das KNN sich selbst im Laufe des Trainings beigebracht und sie entsprechen nicht menschlichen Maßstäben. Wir würden diese Objekte unterscheiden nach Merkmalen wie etwa „ist rund und rot“ -> Apfel, „ist länglich und grün“ -> Birne. Ein Computer kann aber mit Begriffen wie „rot“ oder „länglich“ nichts anfangen. Er findet eigene Unterscheidungsmerkmale, die vielleicht heißen könnten „hat Durchschnittlich einen Rotwert von X Prozent“ oder die sehr viel abstrakter sind. Sie stehen aber nirgendwo zum Nachlesen, sie sind implizit in der Gesamtformel enthalten, die alle Neuronen ausmachen.

Die Entscheidungswege der KI, also der Grund, warum sich die KI für „Apfel“ entscheidet, sind nicht direkt für uns nachvollziehbar, weshalb man manchmal auch von der „Black Box“ spricht, da für die menschliche Intuition nicht offensichtlich ist, wie ein KNN zu seiner Einschätzung gekommen ist (denn ein Computer denkt nicht in „länglich“ oder „grün“).

Jedoch lässt sich der Entscheidungsweg zu jedem einzelnen Bild im Nachhinein genau nachvollziehen, wenngleich sie auch durch eine sehr komplizierte mathematische Formel dargestellt wird, die durch Tausende oder Millionen von Parametern bestimmt wird.

Jedes Neuronale Netz ist nur so gut wie seine Trainingsdaten. Deshalb ist es wichtig, gut sortierte und einheitlich strukturierte Daten zu verwenden, wenn ein KNN trainiert werden soll. Und hier wird klar, warum Unternehmen wie Facebook oder Google so viele Daten sammeln: Je mehr Daten sie haben, desto besser können sie künstliche Netze auf diese loslassen, diese trainieren und auswerten. Und genau deshalb ist es wichtig für Unternehmen, viele Daten zu sammeln.

Limitationen von neuronalen Netzen

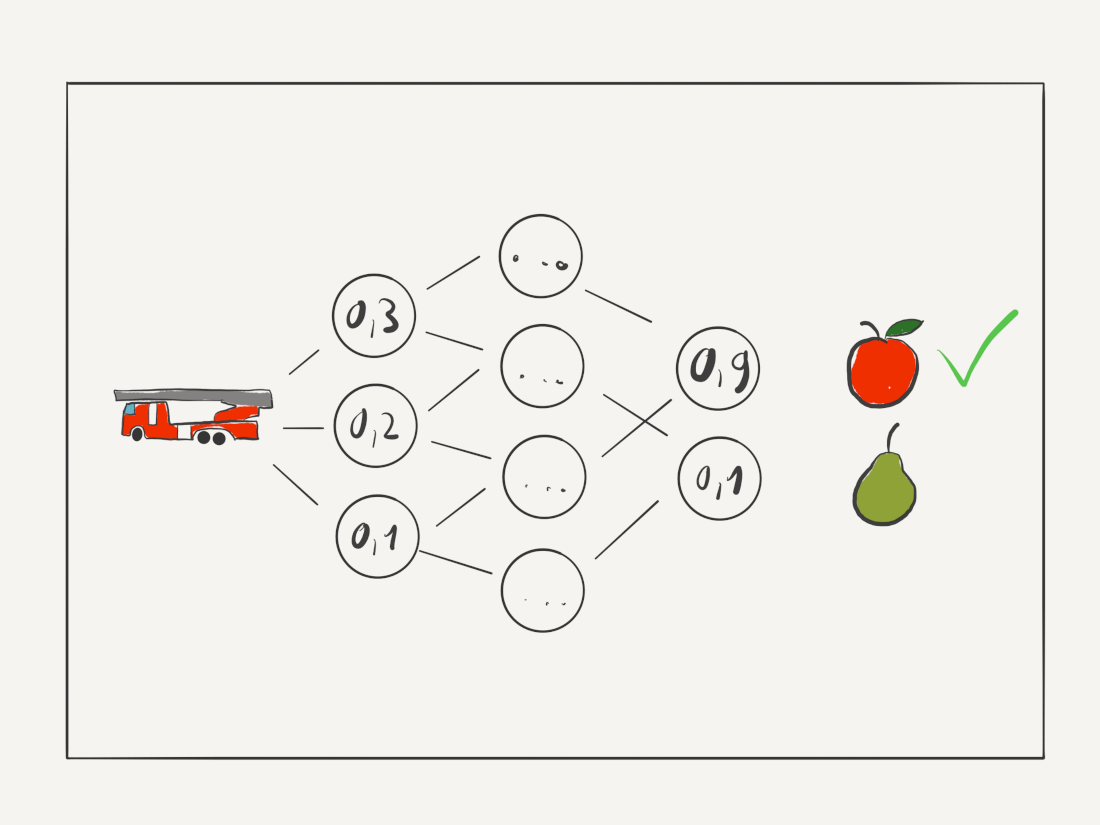

Unser Äpfel-und-Birnen-Beispiel zeigt aber zugleich eine Limitierung von KNNs auf: Werden sie plötzlich mit Bildern von Feuerwehrautos konfrontiert, können sie damit nichts anfangen – oder ordnen sie fälschlich als Äpfel ein. Um mit neuen, andersartigen Informationen umgehen zu können, müsste ein KNN wiederum erneut trainiert werden. Es muss also einen Datensatz geben, der Antworten auf ein eng umfasstes Fragengebiet geben kann, damit ein neuronales Netz optimal arbeitet.

Ein Garten an neuronalen Netzen

Neuronale Netze gibt es in vielen unterschiedlichen Formen und Funktionsweisen, das oben dargestellte ist nur ein Prinzip unter vielen. Bekanntheit erlangten in den letzten Jahren die Deep Neuronal Networks, in denen mehrere Ebenen von Neuronen hintereinandergeschaltet werden, um genauer zu arbeiten, ähnlich unseres Beispiels. Andere Netze wie Convolutional Neural Networks werden zur Bilderkennung eingesetzt und können dort bereits treffsicherer Bilder erkennen als Menschen. Genetic Neural Networks nehmen sich die Natur der Evolution zum Vorbild, in ihr treten zahlreiche KNN in einem Wettbewerb gegeneinander an, anstatt das eines immer weiter mit Daten feinjustiert wird; die besten kommen weiter, die schlechtesten werden verworfen.

Beispiele für neuronale Netze in 2022

In der letzten Zeit haben KNN für Aufmerksamkeit gesorgt, die im Bereich des Natural Language Processing – also der Verarbeitung von natürlicher Sprache – arbeiten. Diese Modelle, so genannte Transformer, arbeiten mit Milliarden von Parametern und brauchen Monate, um trainiert zu werden.

Man kann sie auch selbst spielerisch ausprobieren: https://transformer.huggingface.co. Eines der neusten und leistungsfähigsten Modelle ist GPT-3, das nach einer Anmeldung bei OpenAI von jedem ausgetestet werden kann: https://openai.com/blog/openai-api/

In Zukunft werden sie immer besser darin, Sätze und Dialoge zu verstehen und selbst zusammenhängende Abschnitte zu verfassen. Im Bereich der Spiele haben KNN in den letzten Jahren für viel Aufmerksamkeit gesorgt. Bekannt dürfte vielen der Sieg der Google-KI AlphaGo im Spiel „Go“ im Jahr 2016 sein (Dokumentation auf Youtube). Seitdem haben sich neuronale Netze stark verbessert und können in immer komplexeren Spielen (Videospielen) Siege gegen Menschen erzielen. Die derzeit leistungsstärkste KI hier ist MuZero, die in der Lage ist, Spiele jeder Art zu erlernen, ohne dass sie im vornherein etwas über die Regeln oder das Layout oder die Funktionsweise kennt.

Eine geradezu schon gruselig fortgeschrittene KI ist Dall-E2, die in der Lage ist, völlig neue Bilder oder Kunstwerke zu kreieren rein auf Basis von Textentwürfen. Jede und jeder kann das OpenAI-Projekt ausprobieren, nach einer Anmeldung auf der Webseite: https://openai.com/dall-e-2/

Ein weiteres wichtiges Forschungsgebiet im Bereich der KNN sind autonome Fahrzeuge, deren Entwicklung in vollem Gange sind. Hier erhielt Mercedes Ende 2021 als weltweit erstes Unternehmen die Genehmigung, unter bestimmten Umständen autonom fahren zu lassen.

Neuronale Netze besser verstehen

Die genaue Funktionsweise von Künstlicher Intelligenz zu verstehen ist nicht einfach. Viele verschiedene Seiten und Projekte nehmen sich dieser Aufgabe an. Wir haben hier ein paar gesammelt, die all jenen weiterhelfen, die tiefer in die Materie eindringen wollen. Die meisten davon sind auf Englisch, aber nicht alles.

- CGP Grey: Der Youtuber CGP Grey hat in einem kurzen Video die Funktion von einer speziellen Form von neuonalen Netzen, den Genetic Neural Networks, verständlich und anschaulich animiert zusammengefasst: How Machines Learn

- Doktor Whatson: Auf Deutsch erklärt Doktor Whatson auf Youtube in 8 Minuten, wie ein neuronales Netz funktioniert, wie es lernt und was man damit macht

- 3Blue1Brown: Dieser Youtuber erklärt in drei Teilen, wie ein Deep Neural Network funktioniert. Die Erklärung ist deutlich komplexer und verwendet ein wenig Mathematik, die jedoch sehr hilfreich ist, um zu verstehen, wie ein Bild in eine mathematische Funktion übersetzt werden kann, wie also die KI „denkt“: What is a neural network?

- Sebastian Lague: Alle Links angesehen? Dann kommt hier von Sebastian Lague eine Zusammenfassung, welche anhand einer Animation sehr gut erklärt, wie aus Formeln künstliche Intelligenz erwächst. Aber Achtung - dieses Video sollte nur ansehen, wer zumindest die Grundbegriffe der KI-Mathematik nachvollziehen kann.

- Neural Network ausprobieren: Auf http://playground.tensorflow.org/ kann jeder einmal selbst mit einem neuronalen Netz im Browser herumspielen. Vor dem Start sollte man jedoch die Anleitung anschauen, denn sonst ist es schwer, die Bedeutung der verschiedenen Parameter zu verstehen.

- Neural Network ausprobieren II: In kürzester Zeit ist das Sprachmodell ChatGPT berühmt geworden für seine beeindruckenden Ergebnisse. Es kann mittels eines Accounts bei OpenAI kostenlos ausprobiert werden.

- Neural Network ausprobieren III: Bilderzeugende KI zeigen anschaulich und leicht verständlich die Möglichkeiten der Technologie. Zwei Modelle kann jeder über das Internet austesten. Einmal die KI DALLE-2, die ebenfalls über OpenAI zugänglich ist und einmal Midjourney, die über einen Discord-Zugang gesteuert werden kann.

- Deep Learning 2022: Zwei us-amerikanische KI-Profis erstellen jedes Jahr einen "State of AI"-Report, der die wichtigsten Entwicklungen in der Branche zusammenfasst. Hier die Präsentation von Ende 2021: https://www.stateof.ai/

Und, jetzt neugierig auf KIs geworden? Das Netzwerk Bremen.AI hilft bei allen Fragen rund um die KI weiter und gibt erste Einblicke in die Technologie.

Erfolgsgeschichten

„Der Blick auf die Smartwatch kann und darf den Besuch bei einer Ärztin oder einem Arzt nicht ersetzen“

Smartwatches, Fitnesstracker und Smartphones sammeln unsere Gesundheitsdaten. Eine große Chance für die Medizin, so Prof. Tanja Schultz an der Universität Bremen. Sie will jetzt eine einzigartige Datenbank für Biosignale aufbauen – jongliert aber gleichzeitig auch mit den Gefahren des Datensammelns.

Mehr erfahrenWie autonome Fahrzeuge sicher durch Bremen und Deutschland rollen

Auf den Straßen sollen autonom fahrende Autos bald selbstverständlich sein. Ohne Menschen wird es aber nicht gehen: Mit dem Bremer Safety Control Centers soll die Fernüberwachung einfach und zugleich sicher werden.

Mehr erfahren14 KI-Unternehmen in Bremen

KI-Unternehmen profitieren in Bremen von einem starken Netzwerk, gut ausgebildeten Fachkräften und einem wachsenden Forschungs- und Wirtschaftsumfeld. 14 Unternehmen, die zeigen, dass KI mehr ist als ChatGPT.

zu Bremen-Innovativ